Van eenvoudige webcrawlers uit de vroege jaren 90 tot baanbrekende innovaties in AI-gestuurde algoritmen, zoekmachineoptimalisatie (SEO) heeft de afgelopen drie decennia een snelle evolutie doorgemaakt. Tijdens deze reis is SEO steeds complexer geworden en steeds fundamenteler voor moderne digitale marketingstrategieën.

Of u nu nieuw bent in het maken van inhoud of een ervaren contentmanager die manieren zoekt om uw online bereik te maximaliseren, inzicht in de geschiedenis van zoekmachines en SEO is essentieel bij het maken van boeiende inhoud die het publiek aanspreekt.

Het is fascinerend om terug te kijken op de evolutie van SEO en te onderzoeken waar we nu staan en welke andere veranderingen in het verschiet liggen. Dus laten we diep duiken in de geschiedenis van zoekmachines en hoe SEO zich in de loop der tijd heeft ontwikkeld!

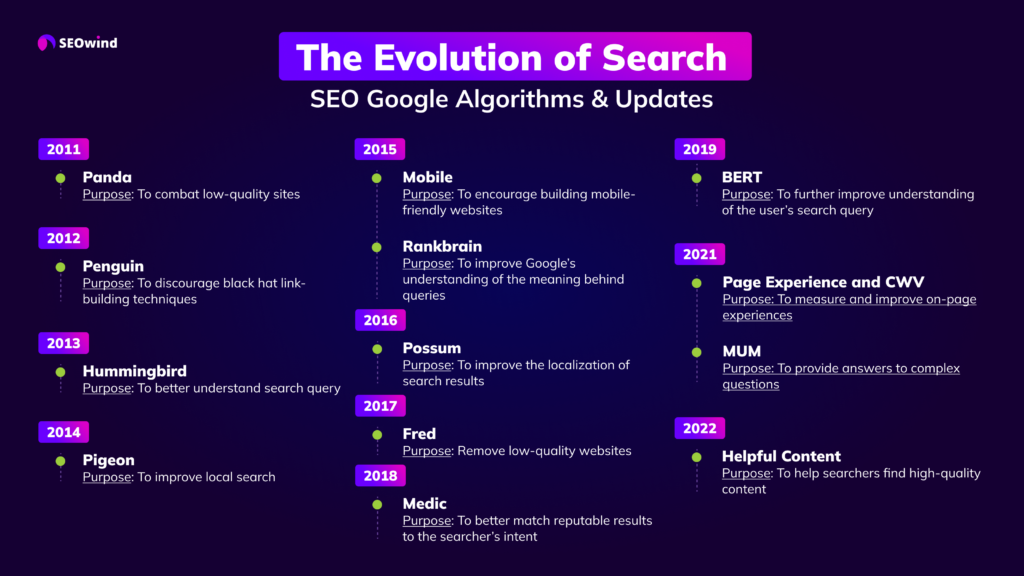

SEO Tijdlijn

Voor degenen die graag direct ter zake komen, hebben we de infographic gemaakt die laat zien hoe de evolutie van search heeft plaatsgevonden, met SEO Google Algoritmes en Updates vanaf 2011 tot nu.

Als u meer wilt weten, blijf dan lezen en geniet van alle details.

De geschiedenis van zoekmachines

Eerst het een en ander. Voordat we ingaan op de evolutie van SEO, laten we beginnen met de geschiedenis van zoekmachines.

Het lijkt misschien wat vroeg om over de geschiedenis van zoekmachines te schrijven. Deze technische of digitale hulpmiddelen bestaan tenslotte pas ongeveer 45 jaar.

Maar voordat er geschiedenis kan worden geschreven, moet de vraag worden gesteld: wat is een zoekmachine?

Eenvoudig gezegd aanvaardt een zoekmachine een zoekopdracht van een gebruiker en zoekt vervolgens het internet af naar artikelen, video's, forums, afbeeldingen en andere gegevens die met deze input verband houden. Deze digitale hulpmiddelen gebruiken algoritmen om de verschillende pagina's te vinden, en organiseren en tonen ze vervolgens op een zogenaamde resultatenpagina. Zodra u de resultaten krijgt, scrolt u door de verschillende websites enz. om de beste informatie voor uw zoekonderwerp te vinden.

Met andere woorden, een zoekmachine is uw informatiehelper die het zware werk voor u doet.

Vergeet niet dat de vroege zoekmachines niet waren zoals de zoekmachines van vandaag. Ze waren zeer primitief en hadden niet zoveel mogelijkheden als de huidige modellen.

Bovendien hadden ze niet veel websites of webpagina's om te doorzoeken. Meestal stond de informatie die deze vroege zoekmachines vonden op de Protocol voor bestandsoverdracht (FTP) sites.

Deze werden handmatig onderhouden en bevatten niet veel informatie. Ze bestonden ook uit gedeelde bestanden en niet uit de bestanden die u tegenwoordig op de resultatenpagina van uw zoekmachine ziet.

Maar zoals met alles, toen het product eenmaal was uitgevonden, kwamen andere briljante mensen erbij en verfijnden het. Dat is wat er gebeurde met de zoekmachines, zoals u binnenkort zult zien.

Wanneer werd de eerste zoekmachine gemaakt?

Simpele vraag, geen simpel antwoord.

Dit is een punt van discussie.

- De meeste websites die de geschiedenis van de zoekmachine documenteren zouden stellen dat Archie de eerste was. Technisch gezien zouden ze gelijk hebben, want het was een zoekmachine. Archie was echter ontworpen om FTP-websites te doorzoeken, niet het world wide web. Hij werd gebouwd in 1987 aan de McGill University (toch zeggen sommige websites dat Archie rond 1990 werd gebouwd en gelanceerd).

- Nadat Archie kwam Jughead of W3Catalog, gemaakt door Oscar Nierstrasz aan de Universiteit van Genève in september 1993. Datzelfde jaar, en 2 maanden later, ontstond Aliweb (Archie Like Indexing for the Web). Dit was wat mensen hebben uitgeroepen tot de eerste zoekmachine voor het wereldwijde web.

- Sommige mensen zetten Veronica voor Jughead, omdat die in 1992 zou zijn ontstaan. Maar alles wat deze zoekfunctie deed was zoeken naar gezochte bestandsnamen en titels die waren opgeslagen in Gopher Index Systemen. Het is misschien geen echte zoekmachine.

- 1993 was een druk jaar voor de creatie van zoekmachines in hun meest primitieve vorm. Er was ook World Wide Wanderer, JumpStation, en RBSE spider dat rond dezelfde tijd werd ontwikkeld. Een van de nadelen van deze vroege systemen was dat er geen resultaten werden gevonden, tenzij je exacte titels in je zoekterm had.

- Vervolgens was 1994 weer een hectisch jaar toen Infoseek, EINet Galaxy en Yahoo werden opgericht.

- In 1995 werden LookSmart, Excite en AltaVista opgericht. AOL kocht dat jaar WebCrawler, en Netscape koos voor Infoseek als standaard zoekmachine.

- Daarna, in 1996, zag het internet de toevoeging van Inktomi: HotBot, Ask.Com, of AskJeeves aan de groeiende lijst van zoekmachines.

- 1996 is ook beroemd om een andere creatie. BackRub werd uitgevonden, en het was misschien wel de eerste zoekmachine die backlinks gebruikte. Wat deze kleine zoekmachine opmerkelijk maakt, is dat het de basis is waaruit Google is voortgekomen.

BackRub was ook de eerste die websites rangschikte op basis van autoriteit en ook rangschikte op basis van citaten. Dit waren de zoekmachines uit de jaren 90 die hielpen de huidige generatie zoekmachines op te bouwen die iedereen vandaag gebruikt.

Wie heeft de zoekmachine uitgevonden?

Als het om geschiedenis gaat, is er altijd veel discussie over de werkelijke datum van uitvinding. Soms vloeit dit debat over naar wie wat creëerde.

- Veel websites vermelden bijvoorbeeld alleen de namen van de universiteiten waar de uitvinding of creatie plaatsvond. Andere websites geven de werkelijke naam van de student of professor die de belangrijkste betrokkene was. Op één website staat bijvoorbeeld dat Archie is bedacht aan de McGill University. Maar op een andere website wordt de naam van de student die Archie heeft gemaakt, vermeld als Alan Emtage.

- Meer mensen herinneren zich de naam van de uitvinder van het world wide web, Sir Tim Berners-Leedie bij CERN in Zwitserland werkte, dan zouden ze zich de naam herinneren van de bedenker van de World Wide Wanderer, Matthew Gray.

- Of ze herinneren zich misschien de namen Bob Kahn en Vint Cerf, die in 1974 de TCP/IP-technologie uitvonden waar het internet tegenwoordig niet meer zonder kan. Ze zullen zich die twee mannen herinneren omdat ze nu voor Google werken, maar ze zullen zich niet herinneren wie Jughead heeft bedacht, Oscar Nierstrasz.

In wezen is het beter om te zeggen dat er een groep individuen was die bestaande ontwerpen en technologie wisten te verbeteren en die de zoekmachine van de jaren '90 uitvonden.

Alle bovengenoemde mannen hadden een hand in de ontwikkeling van de moderne zoekmachines die websites rangschikken en u helpen snel de informatie te vinden die u nodig hebt.

Wanneer is SEO begonnen? SEO achtergrond

Er is de legende, en hier is de werkelijkheid. De meeste mensen zullen voor de legende gaan, omdat die interessanter is en een verband legt met rockmuziek.

Dus laten we dat doen.

De legende zegt dat de manager van de beroemde rockgroep Jefferson Starship was boos over de lage ranking die zijn band kreeg op verschillende zoekmachines.

Zoals het verhaal gaat, was hij degene achter de ontwikkeling van SEO of zoekmachine optimalisatie. Het jaar waarin hij begon was vóór de officieel erkende start van SEO praktijken.

De officiële start zou hebben plaatsgevonden in 1997. SEO begon waarschijnlijk in 1991, toen de eerste zoekmachines op het world wide web verschenen. Toch werd de term pas in februari 1997 gebruikt door John Audette van Multimedia Marketing Group.

Het is mogelijk dat er andere verhalen zijn over hoe SEO is begonnen. Veel mensen kunnen de eer aan BackRub toekennen omdat het begon met het gebruik van autoriteit en citatie notatie om websites te rangschikken op zijn resultatenpagina.

Als men eerlijk wil zijn, moet men zeggen dat SEO lang voor 1997 en BackRub begon, omdat gebruikers van het wereldwijde web trefwoorden moesten gebruiken om de informatie te vinden die ze nodig hadden over een bepaald onderwerp. Trefwoorden zijn altijd een top SEO-strategie geweest, en die zijn minstens 6 tot 10 jaar ouder dan citaten en autoriteit.

Hoe is SEO geëvolueerd?

Hoewel Google de dominante speler is geweest in de ontwikkeling van SEO, kwam zijn bijdrage en dominantie pas tot stand lang nadat SEO zich had ontwikkeld tot een meer geavanceerd niveau.

Er is altijd een strategie geweest die eigenaren van websites hanteerden om een hogere zichtbaarheid te krijgen, en het zijn de strategieën die veranderden naarmate men andere behoeften bleef zien waaraan moest worden voldaan.

In het begin was het voldoende om alleen trefwoorden te gebruiken om mensen naar uw website te krijgen. Er waren niet zoveel websites, en niemand had echte inhoud nodig om verkeer naar zijn deur te leiden.

Naarmate de concurrentie toenam, namen ook de verschillende strategieën toe. Trefwoorden waren niet langer voldoende, en website-eigenaren gingen over op e-mailmarketing, linkbuildingen zelfs betaalde advertenties op de weinige sociale media die toen bestonden.

Na verloop van tijd ontstond een andere behoefte. De vraag was, nu je het verkeer hebt, hoe houd je je bezoekers ter plaatse om een aankoop te doen of een formulier in te vullen, enzovoort? Deze behoefte leidde tot de ontwikkeling van geweldige inhoud.

Maar geweldige inhoud was niet genoeg, dus werd gebruikerservaring een hoge prioriteit. Dit leidde tot het gebruik van video's, afbeeldingen en eenvoudige navigatie om de bezoeker ter plaatse te houden tot hij een klant wordt.

Deze strategieën worden nog steeds gebruikt, maar ze zijn verfijnd door de dominantie van Google en het gebruik van algoritmen en andere rangschikkingscriteria die veel waarde hechten aan verschillende website-inhoud en bruikbaarheid.

SEO begin: 'Het Wilde Westen': De jaren '90

De term Wild West kan misleidend zijn met betrekking tot het internetgebruik in de jaren '90. Maar tegelijkertijd kan het ook een treffende analogie zijn vanwege de beperkingen van de overheid en de technologiebedrijven in die tijd.

Het oude wilde westen van de Amerikaanse geschiedenis had wetten, maar het was moeilijk ze te handhaven. Ook verzonnen sheriffs en rechters hun eigen wetten en straffen voor hen die zij als wetsovertreders beschouwden.

Deze situatie maakte het voor criminelen en revolverhelden gemakkelijk om van county naar county te trekken, want als ze in de ene county gezocht werden, konden ze naar een andere gaan waar ze niet gezocht werden en het leven leiden zoals ze wilden.

Dit maakte het soms erg gevaarlijk om te leven tijdens die wilde westen dagen. Hetzelfde geldt voor het internet van de jaren '90. Rechtshandhaving was niet universeel als er wetten waren die betrekking hadden op specifieke internetactiviteiten.

Internetgebruikers hadden in die tijd veel vrijheid om bepaalde trefwoorden te gebruiken als websitetitel, bijvoorbeeld www.whitehouse.com, wat een pornosite was. In de jaren 90 was vanwege de kinderschoenen van het internet nog niet veel bekend, en weinig mensen dachten dat er niet veel kwaad kon op het world wide web.

Toen de regeringen zich bewust werden van de gevaren van het vrije internet, begonnen de wetten te veranderen en werden er strengere controles ingesteld op de gebruikers en de zoekmachines.

Het grootste verschil tussen het internet van vandaag en dat van de jaren '90 is waarschijnlijk niet alleen de regelgeving voor het internet, maar ook dat de snelheid een stuk lager lag en er minder junk-sites waren.

Naarmate de technologie groeide en veranderde, veranderde ook het internet, wat uiteindelijk de aandacht trok van verschillende regeringen die meer wetten invoerden om die vrijgevochten website-eigenaars en -gebruikers in te tomen.

Black Hat Tactics krijgen een slechte reputatie: Begin jaren 2000 - 2005

Toen de eerste zoekmachine werd gemaakt, waren er misschien niet veel regels om te volgen. Zoekmachines stonden nog in de kinderschoenen, en niet veel mensen hadden een goed idee van wat goede en slechte SEO-praktijken waren.

Maar naarmate de jaren verstreken en de vroege zoekmachines zich ontwikkelden, werden regels de norm. De regels die zich samen met de zoekmachines ontwikkelden, verdeelden SEO uiteindelijk in de witte hoed en zwarte hoed divisies.

De white hat SEO werd beschouwd als een ethische strategie, terwijl de black hat SEO-praktijken onethisch waren. Deze laatste zouden de regels van de zoekmachine overtreden. De mensen die zwarte hoed technieken gebruikten deden dat vanwege de positieve resultaten die het opleverde voor een website die ze gebruikte.

Als u niet denkt dat dit slechte strategieën zijn, dan zijn ze dat wel. Het gebruik ervan op uw website kan u in grote problemen brengen. De reden daarachter is dat de zwarte hoed strategieën schendingen zijn van de servicevoorwaarden van de zoekmachine.

Als u wordt betrapt op het gebruik van deze strategieën, zullen uw website en uw bedrijf daaronder lijden. Drie veel voorkomende black hat trucs zijn:

- keyword stuffing,

- witte letters op een witte achtergrond, of

- aankoop links.

Het gebruik van deze verschillende onethische technieken kan uw website de-indexeren, het zal zijn rankings en webverkeer verliezen, en u kunt zelfs uw bedrijf moeten sluiten.

De kortetermijnwinst die u behaalt met deze onethische strategieën wordt tenietgedaan zodra Google of een andere zoekmachine ontdekt dat u ze gebruikt. Wat ze hun slechte reputatie geeft, is het feit dat de zoekmachine vindt dat die technieken tegen de regels zijn en een oneerlijk speelveld creëren voor mindere websites.

Om een goede reputatie voor je website te behouden, je ranking en verkeer op peil te houden, enzovoort, moet je doen wat de zoekmachines white hat noemen. SEO strategieën de hele tijd.

De Google-revolutie

Larry Page en Sergey Brin gingen naar de Stanford Universiteit of zaten daar toen ze hun kleine zoekmachine maakten. Het was gewoon een zoekmachine met een twist. Ze voegden een paar rangschikkingscriteria toe om de vele websites die in de afgelopen 5 tot 6 jaar online waren gekomen te helpen sorteren.

Het bedrijf heette toen nog niet eens Google. Het heette BackRuben zijn oprichters hadden zeer grote ambitieuze doelen toen zij deze zoekmachine begonnen.

Deze twee vonden geen nieuw product uit; zij bouwden slechts voort op wat al bestond en gingen over tot verbetering van die bestaande ontwerpen en operaties. Maar er vonden twee dingen plaats die de weg vrijmaakten voor Google, of BackRub, om een reus in deze industrie te worden.

Page Rank Formule

Ten eerste leden andere vroegere zoekmachines onder het misbruik en oneigenlijk gebruik van trefwoorden. Sommige hadden ook problemen met de inhoud, omdat keyword stuffing en verborgen tekst de norm werden in de jaren 90.

De oprichter van Google, Larry Page, ontwikkelde de Page Rank Formula, die hielp deze rommel op te ruimen en begon met het gebruik van autoriteit als criterium voor rankings. BackRub, in die tijd, was in staat om zich te ontdoen van veel van de spam die het internet verpestte.

Google Web Crawler

De tweede gebeurtenis die Google naar de voorgrond stuwde, was het partnerschap met Yahoo. Yahoo gebruikte Google voor zijn webpagina's, en dat was alles wat de zoekmachine nodig had om de dominante speler op het internet te worden.

Het was Google's webcrawler en Page Rank-algoritme dat revolutionair was en Google hielp de krachtpatser te worden die het vandaag is. Omdat Google besloot dat linkbuilding erg belangrijk was, sprong iedereen aan boord en begon de SEO linkbuilding strategie.

Dat was een probleem dat het bedrijf in latere jaren moest aanpakken. Google stopte echter niet met het revolutioneren van de zoekmachine. Ze ontwikkelden hun toolbar, die de page rank scores van websites gaf.

Dit werd gestimuleerd door zijn verschijning op Microsoft's Internet Explorer. Dit betekent niet dat Google geen fouten heeft gemaakt. De oorspronkelijke Adsense werd een probleem, en net als bij linkbuilding moest het bedrijf veranderingen aanbrengen en het probleem oplossen dat ze aanvankelijk hadden veroorzaakt.

De Google-revolutie veranderde het landschap van de zoekmachines en de manier waarop websites werden gerangschikt.

Hoe zijn de algoritmen van Google veranderd?

Google heeft een zeer complex algoritmesysteem gecreëerd om websites te rangschikken, enz. De algoritmen zijn ontworpen om gegevens uit zijn index te halen en de resultaten onmiddellijk op zijn website te plaatsen.

Hiervoor moest de zoekmachine echter rankingfactoren combineren met hun algoritmen om ervoor te zorgen dat de meest relevante websites op de bovenste plaatsen van de pagina met zoekresultaten terechtkwamen.

Toen Larry Page in 1996 PageRank creëerde, was dat een revolutionaire verandering in de rankingsystemen. Toch duurde het nog 7 jaar voordat Google wijzigingen aanbracht in het algoritme.

2003 Google Florida

Toen ontstond Florida. Google ontwierp deze algoritme-update om websites uit te filteren die links van lage kwaliteit bevatten. Helaas voor veel websites en kleine bedrijven bracht Google deze upgrade met Kerstmis uit waarin ook verkeerd gelabelde links werden opgenomen. Dit deed veel bedrijven op dat moment pijn.

2004 Google Trust Rank

Het jaar daarop introduceerde Google TrustRank. Het filterde de websites uit die zwarte-hoedtechnieken en spam gebruikten. Het gaf ook een betrouwbaarheidsbeoordeling van verschillende websites, zodat gebruikers van de zoekmachine toegang kregen tot sites van topkwaliteit.

Deze paar voorbeelden geven iedereen een beetje inzicht in hoe Google internetzoekopdrachten beter wilde maken voor internetgebruikers. Vanaf 20 september heeft Google zijn laatste wijziging van zijn kernalgoritme vrijgegeven.

Het probleem met het bijhouden van deze veranderingen is dat Google de neiging heeft er elk jaar duizenden uit te brengen. Het is niet meer zoals vroeger, toen ze er elk jaar maar een paar introduceerden.

2010 Google Caffeine

Google Caffeine was een belangrijke update van Google's zoekmachine-algoritme in 2010. Het was bedoeld om de snelheid, nauwkeurigheid en relevantie van de zoekresultaten te verbeteren.

Het belangrijkste kenmerk van de update was de verhoogde indexeringssnelheid, waardoor webpagina's veel sneller en nauwkeuriger konden worden geïndexeerd dan voorheen.

2011 Google Panda

Het jaar daarop, in 2011, kwam Google met zijn eerste grote algoritme-update, bekend als "Google Panda".

Deze update was bedoeld om de zichtbaarheid van sites van lage kwaliteit in SERP's te verminderen en sites van hogere kwaliteit te belonen. Het had een grote impact op websites: sommige sites zagen hun SERP-ranking dramatisch dalen. Google Panda introduceerde ook een reeks criteria voor het beoordelen van de kwaliteit van een website, zoals de diepte van de inhoud, de relevantie van trefwoorden en de gebruikerservaring.

2011 Google Freshness

Later in het jaar lanceerde Google zijn Freshness-update. Deze update richtte zich op de actualiteit van de inhoud, wat betekende dat Google waarde begon te hechten aan inhoud die recenter was.

Pagina's die al een tijdje niet waren bijgewerkt, werden naar beneden verplaatst in de SERP's, terwijl die welke recenter waren voorrang kregen.

2011 Schema

In 2011 werd schema markup gecreëerd als een soort microdata om zoekmachines te helpen de intentie van een zoekopdracht te begrijpen. Schema.org toont alle mogelijke varianten van schema markup.

Rankings houden geen rekening met schema. Schema daarentegen kan je zichtbaarheid in de resultatenpagina's van zoekmachines (SERP's) opleveren door middel van rich en featured knipsels.

2012 Google Penguin

De Google Penguin update was gericht op web spam, met name sites die manipulatieve link-building tactieken gebruikten om hogere rankings te bereiken. De update had gevolgen voor miljoenen websites en veel bedrijven die twijfelachtige linkbuildingstrategieën gebruikten, zagen hun rankings dalen. Het was de grootste update van Google's algoritme sinds Panda en had een grote impact op de SEO-industrie.

2013 Google Kolibrie

In 2013 bracht Google het Google Hummingbird-algoritme uit, en dat veranderde de manier waarop we op internet zoeken voorgoed. Voor velen was Hummingbird de belangrijkste wijziging van Google's fundamentele algoritme sinds de introductie ervan in 2001.

Het algoritme is ontworpen om de nauwkeurigheid van de zoekresultaten te verbeteren door de natuurlijke taal van zoekopdrachten beter te begrijpen.

Dingen, geen strings. Met de Knowledge Graph kun je zoeken naar dingen, mensen of plaatsen die Google kent en krijg je meteen informatie die relevant is voor je zoekopdracht. Google gebruikt deze gegevens om zijn zoekresultaten te verbeteren.

Wanneer iemand zoekt naar een van de miljarden entiteiten of feiten die in de kennisgrafiek zijn opgeslagen, kunnen verschillende soorten "kennispanelen", "kennisvakken" en "kenniscarrousels" verschijnen.

Er wordt niet alleen gekeken naar de trefwoorden die u intypt, maar ook naar de context van de zoekopdracht. Dit betekent dat het de onderliggende bedoeling achter elke zoekopdracht beter kan begrijpen en relevantere resultaten kan bieden. Het is gemaakt om vragen in natuurlijke taal en conversatiezoeken beter af te handelen.

2014 Google Duif

Google revolutioneerde de online ervaring voor lokale bedrijven met hun 'Pigeon' algoritme update. Het werd gemakkelijker dan ooit om relevante en nabije zoekresultaten te vinden. Voor degenen die hun SEO-praktijken optimaliseren, was Pigeon een krachtig hulpmiddel dat een betere zichtbaarheid mogelijk maakte wanneer gebruikers in de buurt zochten - waardoor eigenaren van kleine bedrijven hoger konden stijgen dan de standaardconcurrentie.

2015 Google Mobiel Update AKA "Mobilegeddon"

Een andere grote update werd door Google uitgebracht in 2015, genaamd "Google Mobilegeddon". Deze update richtte zich op het stimuleren van websites die geoptimaliseerd waren voor mobiele apparaten. Dit betekende dat sites die niet geoptimaliseerd waren voor mobiele apparaten moeilijker te vinden zouden zijn in de zoekmachineresultaten - en dus minder bezoekers zouden krijgen.

Snellere, betere, contextuele zoekresultaten: Eind 2010 - 2020

Google heeft de afgelopen jaren enorme vooruitgang geboekt om zijn gebruikers snellere, nauwkeurigere en meer contextuele zoekresultaten te bieden.

Om te beginnen heeft Google een aantal snelheidsverbeteringen doorgevoerd in zijn zoekmachine. Pagina's laden nu sneller dan ooit tevoren en de algoritmen van Google zijn veel efficiënter geworden in het leveren van relevante resultaten.

Google heeft ook aanzienlijke vooruitgang geboekt op het gebied van kunstmatige intelligentie (AI). Van spraakherkenningstechnologie via beeldherkenning tot algoritmen voor machinaal leren: AI wordt steeds meer gebruikt om de gebruikerservaring op de platforms van Google te verbeteren.

2015 Google Rankbrain

2015 was een groot jaar voor Google, en de introductie van Rankbrain was zeker een belangrijk moment.

Rankbrain is een machine-leersysteem dat Google gebruikt om zoekresultaten te helpen sorteren. Het gebruikt kunstmatige intelligentie om de resultaten van zoekopdrachten te analyseren en helpt Google om gebruikers relevantere resultaten te bieden.

2016 Google Possum

Het is ontworpen om meer gelokaliseerde resultaten te bieden voor lokale zoekopdrachten, en het kan een grote impact hebben op lokale zoekmachine optimalisatie (SEO) inspanningen.

In de kern is Possum ontworpen om te voorkomen dat resultaten elkaar teveel overlappen en om lokale bedrijven beter te laten concurreren met nationale of internationale bedrijven. Het houdt bij de presentatie van resultaten rekening met het fysieke adres van de zoeker en het adres van het bedrijf in kwestie.

2017 Google Fred

Dit algoritme werd ontworpen om ineffectieve websites die een buitensporig aantal advertenties en een laag aantal kwalitatief hoogstaande stukken inhoud bevatten, verder te bestraffen.

Als uw website onethische zoekmachineoptimalisatiestrategieën heeft gebruikt, hebt u waarschijnlijk een daling van het verkeer opgemerkt nadat Google Fred had aangenomen.

2018 Google Medic

Dit algoritme helpt websites met medische autoriteit, zoals de Cleveland Clinic en de Mayo Clinic, te rangschikken boven websites die helemaal geen medische autoriteit hebben.

Wie Dr. Google allerlei medische vragen stelde en antwoorden kreeg, weet hoe cruciaal het is om betrouwbare medische bronnen in uw zoekresultaten te hebben.

2019 BERT

Niet alle veranderingen zijn echter merkbaar, maar ze zijn wel effectief, en allemaal proberen ze de zoekinspanningen van de internetgebruiker te verbeteren. Een voorbeeld is dat de BERT-verandering van 2019 bedoeld was om de Hummingbird-verandering van 2013 te verbeteren.

BERT is ook ontworpen om te kijken naar zoekintentie en naar long-tail sleutelwoorden. BERT moest prioriteit geven aan deze SEO-strategieën.

2019 Rich Snippet Review

Featured Snippets zijn een speciaal type zoekresultaat dat Google bovenaan de resultatenpagina van de zoekmachine weergeeft. Deze snippets zijn meestal afkomstig van de inhoud van een website en bevatten een samenvatting van het antwoord op de vraag van een gebruiker en een link naar de oorspronkelijke website.

Iedereen wil er bij horen, maar weinigen weten hoe ze het voor elkaar moeten krijgen.

Maar als het je lukt om in een Featured Snippet te komen, heb je de jackpot gewonnen! Bij elke zoekmachinequery kan een Featured Snippet staan, dus je inhoud kan veel exposure krijgen.

Maar daar komen is niet eenvoudig en vereist veel vallen en opstaan.

Maar als het je lukt, pluk je er snel de vruchten van.

2019 Google's belangrijkste kwaliteitsupdates

De kernupdates van Google zijn een belangrijk onderdeel van het algoritme sinds de invoering ervan in 2000. Het kernalgoritme van Google bestaat uit een reeks regels en richtlijnen die bepalen welke websites verschijnen voor een bepaalde zoekopdracht. Deze updates worden periodiek uitgebracht om de resultaten van de zoekmachine up-to-date en relevant te houden.

De belangrijkste updates van Google zijn bedoeld om de relevantie van de zoekresultaten te verbeteren door ervoor te zorgen dat de meest relevante inhoud als eerste wordt weergegeven.

Google wil ervoor zorgen dat gebruikers de best mogelijke resultaten krijgen voor hun zoekopdrachten, dus inhoud van hoge kwaliteit is essentieel voor een succesvolle website. Dit omvat inhoud die goed gestructureerd en correct geformatteerd is en accurate informatie bevat.

Betere gebruikerservaring, context en waarde: 2020 tot nu

2021 Page Experience en Core Web Vitals (CWV)

Google streeft naar een aangenamere webervaring voor alle gebruikers, ongeacht de browser die ze gebruiken of het type apparaat.

Er wordt gekeken naar pagina-ervaring over hoe gemakkelijk en waardevol gebruikers hun tijd op uw website vinden, ongeacht of uw website de informatie bood die ze zochten. Zij meten de paginaprestaties op basis van vijf belangrijke elementen: mobiele vriendelijkheid, veilig browsen, naleving van het HTTPS-beveiligingsprotocol en opdringerige interstitials, alsmede Core Web Vitals.

Core Web Vitals is Google's manier om de gebruikerservaring van een website te meten. Het evalueert de snelheid waarmee een pagina de belangrijkste inhoud laadt, hoe gemakkelijk het is om de weg te vinden en of zaken als scrollen soepel verlopen.

2021 Google Multitask Unified Model (MUM)

Google revolutioneert zijn zoekmachine verder met de introductie van Multitask Unified Model (MUM), een 1000 keer krachtigere evolutie dan BERT. MUM combineert natuurlijke taalverwerking en verschillende andere technologieën, waardoor Google complexe gebruikersvragen kan beantwoorden en een nog beter gecontextualiseerde ervaring voor gebruikers kan creëren. Het doel van MUM is om slechts één model te gebruiken dat getraind is om tegelijkertijd te indexeren, informatie op te zoeken en te rangschikken.

2022 Google Nuttige inhoud

Google introduceert Helpful Content Update om zijn gebruikers verder de best mogelijke ervaring te bieden. Het stimuleert origineel, nuttig en gebruiksvriendelijk materiaal in de zoekresultaten. Dit unieke signaal helpt beoordelingssystemen inhoud te identificeren die levert wat bezoekers verwachten en nodig hebben - waardoor meer zichtbaarheid wordt gegeven aan degenen die boeiende, informatieve en waardevolle bronnen maken voor hun publiek. Inhoud die niet voldoet aan de verwachtingen van bezoekers wordt ook geweerd, zodat mensen altijd kwaliteitsinformatie krijgen.

Belangrijkste opmerkingen

Zoekmachines hebben een lange weg afgelegd sinds de begindagen van het internet. Ze blijven zich ontwikkelen en veranderen systematisch. Aangezien Google zijn algoritme aanpast, is het belangrijk voor ons om op de hoogte te blijven van deze veranderingen en onze SEO strategieën dienovereenkomstig. U vraagt zich misschien af waar de toekomst van zoeken ons zal brengen? Alleen de tijd zal het leren. Maar één ding is zeker: de wereld van SEO verandert en evolueert altijd. En we moeten voorbereid zijn op wat komen gaat.