Von den einfachen Web-Crawlern der frühen 90er Jahre bis hin zu bahnbrechenden Innovationen bei KI-gesteuerten Algorithmen hat die Suchmaschinenoptimierung (SEO) in den letzten drei Jahrzehnten eine rasante Entwicklung erlebt. Im Laufe dieser Entwicklung ist SEO immer komplexer und für moderne digitale Marketingstrategien immer wichtiger geworden.

Ganz gleich, ob Sie neu im Bereich der Inhaltserstellung sind oder als erfahrener Content Manager nach Möglichkeiten suchen, Ihre Online-Reichweite zu maximieren - das Verständnis der Geschichte von Suchmaschinen und SEO ist der Schlüssel zur Erstellung überzeugender Inhalte, die das Publikum ansprechen sollen.

Es ist faszinierend, auf die Entwicklung der Suchmaschinenoptimierung zurückzublicken und zu erkunden, wo wir heute stehen und welche weiteren Veränderungen sich am Horizont abzeichnen könnten. Tauchen wir also ein in die Geschichte der Suchmaschinen und wie sich SEO im Laufe der Zeit entwickelt hat!

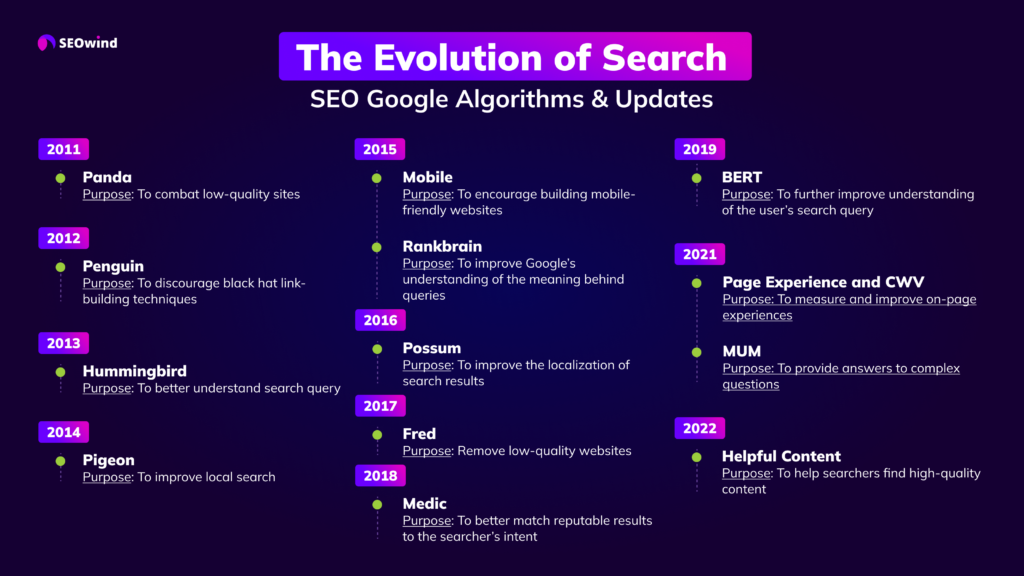

SEO-Zeitleiste

Für diejenigen, die es gerne direkt auf den Punkt bringen, haben wir eine Infografik vorbereitet, die zeigt, wie sich die Suche entwickelt hat und die SEO Google Algorithmen und Updates von 2011 bis heute präsentiert.

Wenn Sie mehr erfahren möchten, lesen Sie weiter und freuen Sie sich über alle Details.

Die Geschichte der Suchmaschinen

Das Wichtigste zuerst. Bevor wir uns mit der Entwicklung von SEO beschäftigen, sollten wir mit der Geschichte der Suchmaschinen beginnen.

Es mag etwas früh erscheinen, über die Geschichte der Suchmaschinen zu schreiben. Schließlich gibt es diese technischen oder digitalen Werkzeuge erst seit etwa 45 Jahren.

Bevor jedoch Geschichte geschrieben werden kann, muss die Frage gestellt werden, was eine Suchmaschine ist.

Vereinfacht gesagt, nimmt eine Suchmaschine eine Benutzeranfrage entgegen und durchsucht dann das Internet gründlich nach Artikeln, Videos, Foren, Bildern und anderen Daten, die mit dieser Eingabe zusammenhängen. Diese digitalen Werkzeuge verwenden Algorithmen, um die verschiedenen Seiten zu finden und sie dann auf einer so genannten Ergebnisseite zu organisieren und anzuzeigen. Sobald Sie die Ergebnisse erhalten, blättern Sie durch die verschiedenen Websites usw., um die besten Informationen zu Ihrem Suchthema zu finden.

Mit anderen Worten: Eine Suchmaschine ist Ihr Informationshelfer, der die harte Arbeit für Sie erledigt.

Denken Sie daran, dass die frühen Suchmaschinen nicht mit den heutigen Suchmaschinen vergleichbar waren. Sie waren sehr primitiv und hatten nicht so viele Funktionen wie die heutigen Modelle.

Außerdem gab es nicht viele Websites oder Webseiten zu durchsuchen. Normalerweise waren die Informationen, die diese frühen Suchmaschinen fanden, auf den Dateiübertragungsprotokoll (FTP)-Seiten.

Diese wurden manuell gepflegt und enthielten nicht viele Informationen. Außerdem bestanden sie aus gemeinsam genutzten Dateien und nicht aus den Dateien, die Sie heute auf der Ergebnisseite Ihrer Suchmaschine sehen.

Aber wie bei allem anderen auch, sobald das Produkt erfunden war, kamen andere brillante Leute hinzu und verfeinerten es. So war es auch bei den Suchmaschinen, wie Sie gleich sehen werden.

Wann wurde die erste Suchmaschine entwickelt?

Einfache Frage, keine einfache Antwort.

Dies ist eine Frage der Debatte.

- Auf den meisten Websites, die die Geschichte der Suchmaschine dokumentieren, wird festgestellt, dass Archie war die erste. Technisch gesehen hätten sie Recht, denn es war eine Suchmaschine. Archie wurde jedoch für die Suche auf FTP-Websites entwickelt, nicht für das World Wide Web. Es wurde 1987 an der McGill University entwickelt (auf einigen Websites steht jedoch, dass Archie um 1990 entwickelt und gestartet wurde).

- Nachdem Archie kam Jughead oder W3Catalog, das von Oscar Nierstrasz an der Universität Genf im September 1993. Im selben Jahr, und 2 Monate später, wurde Aliweb (Archie Like Indexing for the Web) entwickelt. Dies war die erste Suchmaschine für das World Wide Web, wie es heißt.

- Manche Leute führen Veronica vor Jughead auf, da sie angeblich 1992 erstellt wurde. Aber alles, was diese Suchfunktion tat, war die Suche nach gesuchten Dateinamen und Titeln, die in Gopher-Indexsystemen gespeichert waren. Sie kann nicht als echte Suchmaschine bezeichnet werden.

- 1993 war ein arbeitsreiches Jahr für die Entwicklung von Suchmaschinen in ihrer primitivsten Form. Es gab auch World Wide Wanderer, JumpStation und RBSE spider, die etwa zur gleichen Zeit entwickelt wurden. Einer der Nachteile dieser frühen Systeme war, dass keine Ergebnisse gefunden wurden, es sei denn, Sie hatten genaue Titel in Ihrer Stichwortsuche.

- 1994 war dann ein weiteres hektisches Jahr, in dem Infoseek, EINet Galaxy und Yahoo ins Leben gerufen wurden.

- 1995 wurden LookSmart, Excite und AltaVista entwickelt, die sich nicht unterkriegen ließen. AOL kaufte in diesem Jahr WebCrawler, und Netscape wählte Infoseek als Standardsuchmaschine.

- Danach, im Jahr 1996, wurde die Liste der Suchmaschinen um Inktomi: HotBot, Ask.Com oder AskJeeves erweitert.

- 1996 ist auch für eine andere Erfindung berühmt. BackRub wurde erfunden, und es war möglicherweise die erste Suchmaschine, die Backlinks verwendete. Was diese kleine Suchmaschine so bemerkenswert macht, ist, dass sie das Fundament ist, aus dem Google hervorging.

BackRub war auch die erste Suchmaschine, die Websites nach ihrer Autorität und nach der Zitierweise einordnete. Dies waren die Suchmaschinen der 90er Jahre, die dazu beigetragen haben, die aktuellen Suchmaschinen zu entwickeln, die heute jeder nutzt.

Wer hat die Suchmaschine erfunden?

Wenn es um Geschichte geht, gibt es immer viele Debatten über das tatsächliche Datum der Erfindung. Manchmal geht diese Debatte auch darauf über, wer was erfunden hat.

- Auf vielen Websites werden zum Beispiel nur die Namen der Universitäten aufgeführt, an denen die Erfindung oder Kreation stattfand. Andere Websites geben den tatsächlichen Namen des Studenten oder Professors an, der der Hauptbeteiligte war. Auf einer Website heißt es zum Beispiel, Archie sei an der McGill University entstanden. Auf einer anderen Website wird der Name des Studenten, der Archie erfunden hat, jedoch als Alan Emtage angegeben.

- Mehr Menschen kennen den Namen des Erfinders des World Wide Web, Sir Tim Berners-Leedie am CERN in der Schweiz gearbeitet haben, als dass sie sich an den Namen des Schöpfers des World Wide Wanderer, Matthew Gray, erinnern würden.

- Oder sie erinnern sich an die Namen Bob Kahn und Vint Cerf, die 1974 die TCP/IP-Technologie erfanden, ohne die das Internet heute nicht mehr auskommt. Sie werden sich an diese beiden Männer erinnern, da sie jetzt für Google arbeiten, aber sie werden sich nicht an den Erfinder von Jughead, Oscar Nierstrasz, erinnern.

Im Grunde ist es besser zu sagen, dass es eine Gruppe von Personen gab, die in der Lage waren, bestehende Designs und Technologien zu verbessern, und die die Suchmaschine der 90er Jahre erfanden.

Alle oben genannten Männer waren an der Entwicklung der modernen Suchmaschinen beteiligt, die Websites bewerten und Ihnen helfen, die gewünschten Informationen schnell zu finden.

Wann hat SEO begonnen? SEO-Hintergrund

Es gibt die Legende und es gibt die Realität. Die meisten Leute mögen sich für die Legende entscheiden, da sie interessanter ist und eine Verbindung zur Rockmusik herstellt.

Also lassen wir das mal so stehen.

Die Legende besagt, dass der Manager der berühmten Rockgruppe Jefferson Starship war verärgert über das niedrige Ranking seiner Band in verschiedenen Suchmaschinen.

Der Geschichte nach war er derjenige, der hinter der Entwicklung von SEO oder Suchmaschinenoptimierung stand. Das Jahr, in dem er anfing, war noch vor dem offiziell anerkannten Beginn der SEO-Praktiken.

Der offizielle Start soll 1997 stattgefunden haben. Die Anfänge von SEO gehen wahrscheinlich auf das Jahr 1991 zurück, als die ersten Suchmaschinen im World Wide Web auftauchten. Dennoch wurde der Begriff erst im Februar 1997 von John Audette von der Multimedia Marketing Group verwendet.

Es ist möglich, dass es andere Geschichten darüber gibt, wie SEO begonnen hat. Viele Leute machen BackRub dafür verantwortlich, da es begann, Autoritäts- und Zitationsangaben zu verwenden, um Websites auf seiner Ergebnisseite zu platzieren.

Wenn man ehrlich sein will, sollte man sagen, dass SEO lange vor 1997 und BackRub begann, als die Nutzer des World Wide Web Schlüsselwörter verwenden mussten, um die Informationen zu finden, die sie zu einem bestimmten Thema benötigten. Schlüsselwörter waren schon immer eine der wichtigsten SEO-Strategien, und sie sind mindestens 6 bis 10 Jahre älter als Zitate und Autorität.

Wie hat sich SEO entwickelt?

Google ist zwar der dominierende Akteur in der SEO-Entwicklung, aber sein Beitrag und seine Dominanz kamen erst lange nachdem SEO sich zu einem fortgeschrittenen Niveau entwickelt hatte.

Es gab schon immer eine Strategie, die von den Inhabern von Websites angewandt wurde, um eine höhere Sichtbarkeit zu erreichen, und es sind die Strategien, die sich änderten, als die Menschen immer wieder andere Bedürfnisse sahen, die erfüllt werden mussten.

Am Anfang genügte es, nur Schlüsselwörter zu verwenden, um Besucher auf Ihre Website zu bringen. Es gab noch nicht so viele Websites, und niemand brauchte echte Inhalte, um Besucher auf seine Seite zu bringen.

Mit dem wachsenden Wettbewerb wuchsen auch die verschiedenen Strategien. Schlüsselwörter reichten nicht mehr aus, und die Website-Besitzer verzweigten sich in E-Mail-Marketing, Linkaufbauund sogar bezahlte Werbung in den wenigen sozialen Medien, die es zu dieser Zeit gab.

Mit der Zeit ergab sich ein weiterer Bedarf. Die Frage, die es zu beantworten galt, lautete: Wie kann man die Besucher auf der Website halten, damit sie einen Kauf tätigen oder ein Formular ausfüllen usw.? Dieses Bedürfnis führte zur Entwicklung von großartigen Inhalten.

Aber großartige Inhalte waren nicht genug, so dass die Benutzerfreundlichkeit eine hohe Priorität erhielt. Dies führte zur Erstellung von Videos, Bildern und einer einfachen Navigation, um die Besucher auf der Website zu halten, bis sie zu Kunden werden.

Diese Strategien werden auch heute noch verwendet, aber sie wurden aufgrund der Dominanz von Google und der Verwendung von Algorithmen und anderen Ranking-Kriterien, die einen hohen Wert auf unterschiedliche Website-Inhalte und Benutzerfreundlichkeit legen, verfeinert.

SEO Anfang: "Der Wilde Westen": Die 90er Jahre

Der Begriff "Wilder Westen" mag in Bezug auf die Internetnutzung in den 90er Jahren irreführend sein. Gleichzeitig kann er aber auch eine treffende Analogie für die Beschränkungen der Regierung und der Technologieunternehmen zu dieser Zeit sein.

Im alten Wilden Westen der amerikanischen Geschichte gab es zwar Gesetze, aber es war schwierig, sie durchzusetzen. Außerdem erfanden Sheriffs und Richter ihre eigenen Gesetze und Bestrafungen für diejenigen, die sie als Gesetzesbrecher betrachteten.

Diese Situation machte es Kriminellen und Revolverhelden leicht, von einem Bezirk zum anderen zu ziehen, denn wenn sie in einem Bezirk gesucht wurden, konnten sie in einen anderen gehen, in dem sie nicht gesucht wurden, und dort ein Leben führen, wie sie wollten.

Das machte das Leben in jenen Tagen des Wilden Westens mitunter sehr gefährlich. Das Gleiche gilt für das Internet in den 90er Jahren. Die Strafverfolgung war nicht universell, wenn es irgendwelche Gesetze gab, die sich mit bestimmten Internetaktivitäten befassten.

Damals hatten die Internetnutzer große Freiheit, bestimmte Schlüsselwörter als Titel für ihre Websites zu verwenden, z. B. www.whitehouse.com, eine Pornoseite. In den 90er Jahren, als das Internet noch in den Kinderschuhen steckte, war noch nicht viel bekannt, und nur wenige Menschen dachten, dass im World Wide Web nicht viel Schaden angerichtet werden könnte.

Als die Regierungen die Gefahren des Internets erkannten, wurden die Gesetze geändert und strengere Kontrollen der Nutzer und Suchmaschinen eingeführt.

Der wahrscheinlich größte Unterschied zwischen dem heutigen Internet und den 90er Jahren besteht nicht nur in den Vorschriften, die das Internet regeln, sondern auch darin, dass die Geschwindigkeit viel langsamer war und es weniger Junk-Sites gab.

Mit der Entwicklung und dem Wandel der Technologie wuchs auch das Internet, was schließlich die Aufmerksamkeit verschiedener Regierungen auf sich zog, die mehr Gesetze einführten, um die freilaufenden Website-Besitzer und -Nutzer in die Schranken zu weisen.

Black Hat-Taktiken bekommen einen schlechten Ruf: Anfang der 2000er Jahre - 2005

Als die erste Suchmaschine ins Leben gerufen wurde, gab es vielleicht nicht viele Regeln zu befolgen. Suchmaschinen steckten noch in den Kinderschuhen, und nicht viele Menschen hatten eine sehr gute Vorstellung davon, was gute und was schlechte SEO-Praktiken sind.

Doch im Laufe der Jahre und der Entwicklung der ersten Suchmaschinen wurden Regeln zur Norm. Die Regeln, die sich zusammen mit den Suchmaschinen entwickelten, teilten SEO schließlich in die weißer Hut und schwarzer Hut Abteilungen.

Die "White Hat SEO" galt als ethische Strategie, während die "Black Hat SEO" Praktiken unethisch waren. Letztere würden gegen die Regeln der Suchmaschine verstoßen. Die Leute, die Black Hat-Techniken einsetzten, taten dies wegen der positiven Ergebnisse, die sie einer bestimmten Website brachten, die sie verwendete.

Wenn Sie nicht denken, dass dies schlechte Strategien sind, dann sind sie es. Wenn Sie sie auf Ihrer Website anwenden, können Sie sich eine Menge Ärger einhandeln. Der Grund dafür ist, dass die Black-Hat-Strategien gegen die Nutzungsbedingungen der Suchmaschine verstoßen.

Wenn Sie bei der Anwendung dieser Strategien erwischt werden, werden Ihre Website und Ihr Unternehmen darunter leiden. Drei gängige Black Hat-Tricks sind:

- Keyword-Stuffing,

- weiße Buchstaben auf weißem Hintergrund, oder

- Links kaufen.

Die Verwendung dieser verschiedenen unethischen Techniken kann dazu führen, dass Ihre Website nicht mehr indiziert wird, ihre Platzierungen und ihren Webverkehr verliert und Sie möglicherweise sogar Ihr Geschäft einstellen müssen.

Der kurzfristige Gewinn, den Sie durch die Anwendung dieser unethischen Strategien erzielen, wird zunichte gemacht, sobald Google oder eine andere Suchmaschine entdeckt, dass Sie diese Techniken anwenden. Was ihnen ihren schlechten Ruf verleiht, ist die Tatsache, dass die Suchmaschine feststellt, dass diese Techniken gegen die Regeln verstoßen und ein unfaires Spielfeld für weniger gute Websites schaffen.

Um den guten Ruf Ihrer Website zu bewahren, Ihre Platzierung und Ihren Traffic zu erhalten usw., müssen Sie das tun, was die Suchmaschinen als "weißen Hut" bezeichnen SEO-Strategien Die ganze Zeit über.

Die Google-Revolution

Larry Page und Sergey Brin besuchten die Stanford University oder waren in Stanford, als sie ihre kleine Suchmaschine entwickelten. Es war nur eine weitere Suchmaschine mit einer Besonderheit. Sie fügten eine Reihe von Ranking-Kriterien hinzu, um die vielen Websites zu sortieren, die in den letzten 5 bis 6 Jahren online gegangen sind.

Zu dieser Zeit hieß das Unternehmen noch nicht einmal Google. Es wurde genannt BackRubund seine Gründer hatten sehr ehrgeizige Ziele, als sie diese Suchmaschine starteten.

Die beiden erfanden kein neues Produkt, sondern bauten lediglich auf dem auf, was bereits existierte, und verbesserten die bestehenden Designs und Abläufe. Aber es gab zwei Dinge, die den Weg für Google oder BackRub ebneten, ein Gigant in dieser Branche zu werden.

Page Rank Formel

Erstens litten andere frühere Suchmaschinen unter dem Missbrauch von Schlüsselwörtern. Einige hatten auch Probleme mit dem Inhalt, da Keyword-Stuffing und versteckter Text in den 90er Jahren zur Norm wurden.

Der Gründer von Google, Larry Page, entwickelte die Page-Rank-Formel, die dazu beitrug, diesen Schlamassel zu beseitigen, und die Verwendung von Autorität als Kriterium für die Rangfolge einführte. BackRub war damals in der Lage, einen Großteil des Spams loszuwerden, der das Internet ruinierte.

Google Web Crawler

Das zweite Ereignis, das Google zum Durchbruch verhalf, war seine Partnerschaft mit Yahoo. Letzteres nutzte Google, um seine Webseiten zu betreiben, und das war alles, was die ehemalige Suchmaschine brauchte, um der dominierende Akteur im Internetspiel zu werden.

Der Web-Crawler und der Page-Rank-Algorithmus von Google waren revolutionär und trugen dazu bei, dass Google zu dem Kraftpaket wurde, das es heute ist. Da Google entschied, dass der Linkaufbau sehr wichtig war, sprangen alle auf den Zug auf und begannen mit der SEO-Linkaufbau-Strategie.

Das war ein Problem, mit dem sich das Unternehmen in späteren Jahren auseinandersetzen musste. Google hörte jedoch nicht auf, die Suchmaschine zu revolutionieren. Das Unternehmen entwickelte eine Symbolleiste, die die Bewertung von Websites in der Rangliste anzeigte.

Dies wurde durch sein Erscheinen im Internet Explorer von Microsoft begünstigt. Das heißt aber nicht, dass Google keine Fehler gemacht hat. Das ursprüngliche Adsense wurde zu einem Problem, und wie beim Linkaufbau musste das Unternehmen Änderungen vornehmen und das Problem lösen, das es ursprünglich verursacht hatte.

Die Google-Revolution hat die Suchmaschinenlandschaft grundlegend verändert und die Art und Weise, wie Websites eingestuft werden, verändert.

Wie haben sich die Google-Algorithmen geändert?

Google hat ein sehr komplexes Algorithmus-System entwickelt, um Websites usw. zu bewerten. Die Algorithmen wurden entwickelt, um Daten aus dem Index abzurufen und die Ergebnisse sofort auf der Website zu veröffentlichen.

Um dies zu erreichen, musste die Suchmaschine jedoch Ranking-Faktoren mit ihren Algorithmen kombinieren, um sicherzustellen, dass die relevantesten Websites auf den ersten Plätzen der Suchergebnisseite landeten.

Als Larry Page 1996 den PageRank entwickelte, war dies eine revolutionäre Veränderung der Rankingsysteme. Es dauerte jedoch noch 7 Jahre, bis Google den Algorithmus änderte.

2003 Google Florida

Damals wurde Florida ins Leben gerufen. Google hat diese Algorithmus-Aktualisierung entwickelt, um Websites herauszufiltern, die minderwertige Links enthalten. Unglücklicherweise für viele Websites und kleine Unternehmen veröffentlichte Google diese Aktualisierung zu Weihnachten, die auch falsch gekennzeichnete Links umfasste. Dies schadete vielen Unternehmen zu dieser Zeit.

2004 Google Vertrauensrang

Im folgenden Jahr führte Google TrustRank ein. Damit wurden Websites herausgefiltert, die Black-Hat-Techniken und Spam verwendeten. Außerdem wurden verschiedene Websites als vertrauenswürdig eingestuft, so dass die Nutzer der Suchmaschine Zugang zu Websites von höchster Qualität erhalten.

Diese wenigen Beispiele geben jedem einen kleinen Einblick, wie Google versucht, die Internetsuche für Internetnutzer zu verbessern. Im September 2022 hat Google seine jüngste Änderung an seinem Kernalgorithmus veröffentlicht.

Das Problem, mit diesen Änderungen Schritt zu halten, ist, dass Google dazu neigt, jedes Jahr Tausende davon zu veröffentlichen. Es ist nicht mehr so wie früher, als sie jedes Jahr nur einige wenige einführten.

2010 Google Koffein

Google Caffeine war eine wichtige Aktualisierung des Google-Suchmaschinenalgorithmus im Jahr 2010. Es wurde entwickelt, um die Geschwindigkeit, Genauigkeit und Relevanz der Suchergebnisse zu verbessern.

Das Hauptmerkmal der Aktualisierung war die erhöhte Indizierungsrate, die es ermöglichte, Webseiten viel schneller und genauer als zuvor zu indizieren.

2011 Google Panda

Bereits im darauffolgenden Jahr, 2011, führte Google sein erstes großes Algorithmus-Update ein, das als "Google Panda" bekannt wurde.

Diese Aktualisierung sollte die Sichtbarkeit von Websites mit geringer Qualität in den SERPs verringern und Websites mit höherer Qualität belohnen. Es hatte erhebliche Auswirkungen auf Websites, wobei einige Websites einen drastischen Rückgang in ihren SERP-Rankings erlebten. Google Panda führte auch eine Reihe von Kriterien zur Beurteilung der Qualität einer Website ein, wie z. B. die Tiefe des Inhalts, die Relevanz der Keywords und die Nutzererfahrung.

2011 Google Freshness

Später im Jahr führte Google sein Freshness-Update ein. Dieses Update konzentrierte sich auf die Aktualität der Inhalte, was bedeutet, dass Google begann, Inhalte zu bewerten, die aktueller waren.

Seiten, die seit längerer Zeit nicht mehr aktualisiert worden waren, wurden in den SERPs nach unten verschoben, während die neueren Seiten Vorrang erhielten.

2011 Schema

Im Jahr 2011 wurde Schema Markup als eine Art von Mikrodaten entwickelt, um Suchmaschinen dabei zu helfen, die Absicht einer Anfrage zu verstehen. Schema.org zeigt alle möglichen Varianten von Schema-Markup an.

Rankings berücksichtigen Schema nicht. Schema hingegen kann Ihnen Sichtbarkeit auf den Suchmaschinenergebnisseiten (SERPs) verschaffen, und zwar mittels Rich- und Featured Schnipsel.

2012 Google Pinguin

Das Google Penguin-Update richtete sich gegen Webspam, insbesondere gegen Websites, die manipulative Linkbuilding-Taktiken einsetzten, um höhere Rankings zu erzielen. Das Update wirkte sich auf Millionen von Websites aus, und viele Unternehmen, die fragwürdige Linkbuilding-Strategien verwendeten, mussten einen Rückgang ihrer Rankings hinnehmen. Es war die größte Aktualisierung des Google-Algorithmus seit Panda und hatte erhebliche Auswirkungen auf die SEO-Branche.

2013 Google Hummingbird

Im Jahr 2013 veröffentlichte Google den Google Hummingbird-Algorithmus und veränderte damit die Art und Weise, wie wir im Internet suchen, für immer. Für viele war Hummingbird die bedeutendste Änderung des grundlegenden Google-Algorithmus seit dessen Einführung im Jahr 2001.

Der Algorithmus wurde entwickelt, um die Genauigkeit der Suchergebnisse zu verbessern, indem er die natürliche Sprache der Suchanfragen besser versteht.

Dinge, nicht Strings. Mit dem Knowledge Graph können Sie nach Dingen, Personen oder Orten suchen, über die Google Bescheid weiß, und erhalten sofort Informationen, die für Ihre Anfrage relevant sind. Google nutzt diese Daten, um seine Suchergebnisse zu verbessern.

Wenn jemand eine Suche nach einer der Milliarden von Entitäten oder Fakten durchführt, die im Knowledge Graph gespeichert sind, können verschiedene Arten von "Wissenstafeln", "Wissensboxen" und "Wissenskarussells" erscheinen.

Dabei werden nicht nur die von Ihnen eingegebenen Schlüsselwörter berücksichtigt, sondern auch der Kontext der Anfrage. Das bedeutet, dass sie die Absicht hinter jeder Anfrage besser verstehen und relevantere Ergebnisse liefern kann. Sie wurde entwickelt, um Anfragen in natürlicher Sprache und konversationeller Suche besser zu bearbeiten.

2014 Google-Taube

Mit dem Algorithmus-Update "Pigeon" hat Google die Online-Erfahrung für lokale Unternehmen revolutioniert. Es machte es einfacher als je zuvor, relevante und nahe gelegene Suchergebnisse zu finden. Für diejenigen, die ihre SEO-Praktiken optimierten, war Pigeon ein leistungsfähiges Instrument, das eine erhöhte Sichtbarkeit ermöglichte, wenn Nutzer in der Nähe suchten - was es Kleinunternehmern erlaubte, höher zu steigen als die normale Konkurrenz.

2015 Google Mobil Update AKA "Mobilegeddon"

Im Jahr 2015 veröffentlichte Google ein weiteres großes Update mit dem Namen "Google Mobilegeddon". Dieses Update konzentrierte sich darauf, die für Mobilgeräte optimierten Websites zu verbessern. Dies bedeutete, dass Websites, die nicht für Mobilgeräte optimiert waren, in den Suchmaschinenergebnissen schwerer zu finden waren - und somit weniger Besucher erhielten.

Schnellere, bessere und kontextbezogene Suchergebnisse: Ende der 2010er Jahre - 2020

Google hat in den letzten Jahren enorme Fortschritte gemacht, um seinen Nutzern schnellere, genauere und kontextbezogenere Suchergebnisse zu liefern.

Zunächst einmal hat Google eine Reihe von Geschwindigkeitsverbesserungen an seiner Suchmaschine vorgenommen. Die Seiten werden jetzt schneller geladen als je zuvor, und die Algorithmen von Google sind bei der Bereitstellung relevanter Ergebnisse viel effizienter geworden.

Google hat auch im Bereich der künstlichen Intelligenz (KI) erhebliche Fortschritte gemacht. Von der Spracherkennungstechnologie über die Bilderkennung bis hin zu Algorithmen des maschinellen Lernens wird KI immer häufiger eingesetzt, um das Nutzererlebnis auf den Google-Plattformen zu verbessern.

2015 Google Rankbrain

2015 war ein großes Jahr für Google, und die Einführung von Rankbrain war sicherlich ein großer Moment.

Rankbrain ist ein maschinelles Lernsystem, das Google bei der Sortierung der Suchergebnisse unterstützt. Es nutzt künstliche Intelligenz, um die Ergebnisse von Suchanfragen zu analysieren und hilft Google, den Nutzern relevantere Ergebnisse zu liefern.

2016 Google Possum

Sie wurde entwickelt, um mehr lokalisierte Ergebnisse für lokale Suchanfragen zu liefern, und sie kann einen großen Einfluss auf die lokale Suchmaschinenoptimierung (SEO) haben.

Im Kern soll Possum verhindern, dass sich die Ergebnisse zu sehr überschneiden und lokalen Unternehmen helfen, besser mit nationalen oder internationalen Unternehmen zu konkurrieren. Possum berücksichtigt bei der Anzeige der Ergebnisse sowohl die physische Adresse des Suchenden als auch die Adresse des betreffenden Unternehmens.

2017 Google Fred

Dieser Algorithmus wurde entwickelt, um ineffektive Websites, die eine übermäßige Anzahl von Werbung und eine geringe Anzahl von qualitativ hochwertigen Inhalten enthalten, weiter abzustrafen.

Wenn Ihre Website unethische Suchmaschinenoptimierungsstrategien verwendet hat, haben Sie höchstwahrscheinlich einen Rückgang der Besucherzahlen bemerkt, nachdem Google Fred eingeführt hat.

2018 Google Medic

Dieser Algorithmus hilft, Websites mit medizinischer Autorität, wie die Cleveland Clinic und die Mayo Clinic, vor solchen zu platzieren, die überhaupt keine medizinische Autorität haben.

Wer Dr. Google eine Reihe von medizinischen Fragen gestellt und Antworten erhalten hat, weiß, wie wichtig es ist, zuverlässige medizinische Quellen in den Suchergebnissen zu haben.

2019 BERT

Nicht alle Änderungen sind jedoch spürbar, aber sie sind effektiv und versuchen, die Suchbemühungen der Internetnutzer zu verbessern. Ein Beispiel ist, dass die BERT-Änderung 2019 die Hummingbird-Änderung von 2013 verbessern sollte.

Der BERT wurde auch entwickelt, um die Suchabsicht sowie die Long-Tail-Schlüsselwörter. BERT sollte diesen SEO-Strategien Vorrang einräumen.

2019 Rich Snippet Überprüfung

Featured Snippets sind eine besondere Art von Suchergebnissen, die Google oben auf der Ergebnisseite seiner Suchmaschine anzeigt. Diese Snippets werden in der Regel aus dem Inhalt einer Website entnommen und enthalten eine Zusammenfassung der Antwort auf die Suchanfrage eines Nutzers sowie einen Link zur ursprünglichen Website.

Jeder möchte dazugehören, aber nur wenige wissen, wie sie es schaffen können.

Aber wenn Sie es schaffen, in ein Featured Snippet zu kommen, haben Sie den Jackpot geknackt! Jede Suchmaschinenanfrage kann potenziell ein "Featured Snippet" enthalten, so dass Ihre Inhalte eine hohe Aufmerksamkeit erhalten.

Aber der Weg dorthin ist nicht einfach und erfordert viel Ausprobieren.

Aber wenn Sie es schaffen, werden Sie in kürzester Zeit die Früchte Ihrer Arbeit ernten.

Die wichtigsten Google-Qualitätsupdates 2019

Die Kern-Updates von Google sind seit ihrer Einführung im Jahr 2000 ein wichtiger Bestandteil des Algorithmus. Der Kernalgorithmus von Google besteht aus einer Reihe von Regeln und Richtlinien, die bestimmen, welche Websites für eine bestimmte Suchanfrage angezeigt werden. Diese Updates werden in regelmäßigen Abständen veröffentlicht, um die Suchmaschinenergebnisse aktuell und relevant zu halten.

Die wichtigsten Aktualisierungen von Google zielen darauf ab, die Relevanz der Suchergebnisse zu verbessern, indem sichergestellt wird, dass die relevantesten Inhalte zuerst angezeigt werden.

Google möchte sicherstellen, dass die Nutzer die bestmöglichen Ergebnisse für ihre Suchanfragen erhalten, weshalb qualitativ hochwertige Inhalte für eine erfolgreiche Website unerlässlich sind. Dazu gehören Inhalte, die gut strukturiert und richtig formatiert sind und genaue Informationen enthalten.

Bessere Nutzererfahrung, Kontext und Wert: 2020 bis heute

2021 Seitenerfahrung und Core Web Vitals (CWV)

Google ist bestrebt, allen Nutzern ein angenehmeres Web-Erlebnis zu bieten, unabhängig von dem verwendeten Browser oder Gerätetyp.

Dabei wird untersucht, wie einfach und wertvoll der Aufenthalt auf Ihrer Website für die Nutzer ist, unabhängig davon, ob Ihre Website die gewünschten Informationen liefert. Sie messen die Seitenleistung anhand von fünf Schlüsselelementen: Mobilfreundlichkeit, sicheres Surfen, Einhaltung des HTTPS-Sicherheitsprotokolls und aufdringliche Interstitials sowie Core Web Vitals.

Core Web Vitals ist Googles Art, die Nutzerfreundlichkeit einer Website zu messen. Bewertet wird, wie schnell die wichtigsten Inhalte einer Seite geladen werden, wie leicht man sich zurechtfindet und ob Dinge wie das Scrollen reibungslos ablaufen.

2021 Google Multitask Unified Model (MUM)

Mit der Einführung von Multitask Unified Model (MUM), einer 1000-mal leistungsfähigeren Entwicklung als BERT, revolutioniert Google seine Suchmaschinenfunktionen weiter. MUM kombiniert die Verarbeitung natürlicher Sprache mit verschiedenen anderen Technologien und ermöglicht es Google, komplexe Nutzeranfragen zu beantworten und ein noch besser kontextualisiertes Erlebnis für die Nutzer zu schaffen. Das Ziel von MUM ist die Verwendung eines einzigen Modells, das für die gleichzeitige Bearbeitung von Indizierung, Informationsabfrage und Ranking trainiert wurde.

2022 Google Hilfreiche Inhalte

Google führt das "Helpful Content Update" ein, um seinen Nutzern ein noch besseres Erlebnis zu bieten. Es fördert originelles, nützliches und nutzerfreundliches Material in den Suchergebnissen. Dieses einzigartige Signal hilft den Rankingsystemen, Inhalte zu erkennen, die den Erwartungen und Bedürfnissen der Besucher entsprechen. So erhalten diejenigen mehr Sichtbarkeit, die ansprechende, informative und wertvolle Ressourcen für ihr Publikum erstellen. Außerdem werden Inhalte aussortiert, die die Erwartungen der Besucher nicht erfüllen, so dass sichergestellt ist, dass die Besucher stets hochwertige Informationen erhalten.

Wichtigste Erkenntnisse

Suchmaschinen haben seit den Anfängen des Internets einen langen Weg zurückgelegt. Sie entwickeln sich weiter und ändern sich systematisch. Da Google seinen Algorithmus aktualisiert, ist es wichtig, dass wir über diese Änderungen auf dem Laufenden bleiben und unsere SEO-Strategien entsprechend. Sie fragen sich vielleicht, wohin uns die Zukunft der Suche führen wird? Das wird nur die Zeit zeigen. Aber eines ist sicher: Die Welt der Suchmaschinenoptimierung verändert und entwickelt sich ständig weiter. Und wir müssen auf alles vorbereitet sein, was als nächstes kommt.