Desde los simples rastreadores web de principios de los 90 hasta las innovaciones revolucionarias de los algoritmos basados en IA, la optimización para motores de búsqueda (SEO) ha experimentado una rápida evolución en las últimas tres décadas. A lo largo de este recorrido, el SEO se ha vuelto cada vez más complejo y fundamental para las estrategias modernas de marketing digital.

Tanto si es nuevo en la creación de contenidos como si es un gestor de contenidos experimentado que busca formas de maximizar su alcance en línea, comprender la historia de los motores de búsqueda y el SEO es clave a la hora de crear contenidos atractivos que atraigan al público.

Es fascinante echar la vista atrás en la evolución del SEO y explorar dónde nos encontramos ahora, así como qué otros cambios podrían estar en el horizonte. Así que vamos a adentrarnos en la historia de los motores de búsqueda y en cómo ha evolucionado el SEO a lo largo del tiempo.

Cronología SEO

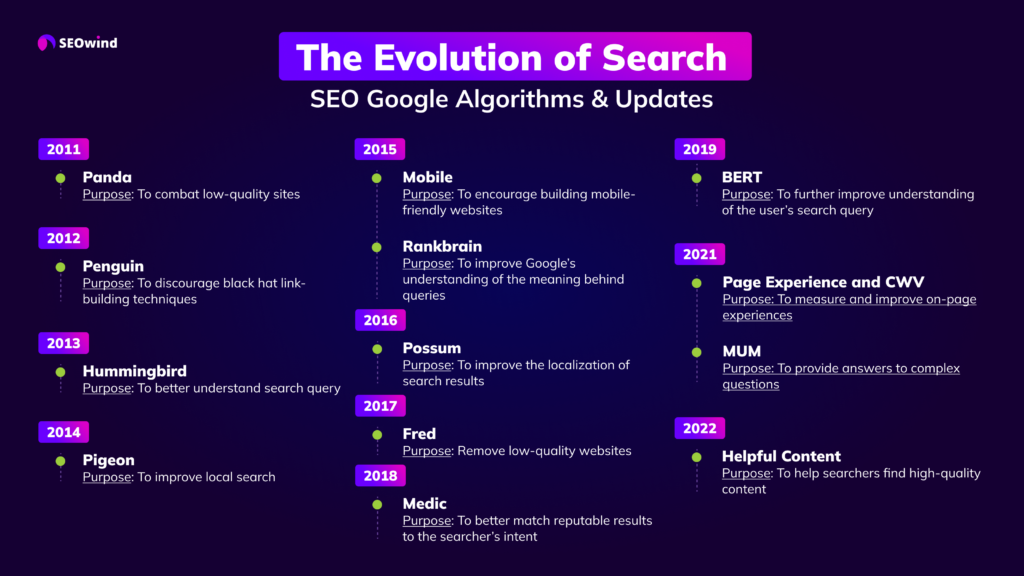

Para aquellos a los que les gusta ir directamente al grano, hemos preparado la infografía que muestra cómo se ha producido la evolución de la búsqueda, presentando los algoritmos y actualizaciones SEO de Google desde 2011 hasta ahora.

Si quiere saber más, siga leyendo y disfrute descubriendo todos los detalles.

Historia de los motores de búsqueda

Lo primero es lo primero. Antes de entrar en la evolución del SEO, empecemos por la historia de los motores de búsqueda.

Puede parecer un poco pronto para escribir sobre la historia de los motores de búsqueda. Al fin y al cabo, estas herramientas técnicas o digitales solo llevan aquí 45 años, aproximadamente.

Pero antes de escribir la historia, hay que preguntarse qué es un motor de búsqueda.

En pocas palabras, un motor de búsqueda acepta una consulta del usuario y, a continuación, realiza una búsqueda exhaustiva en Internet de artículos, vídeos, foros, imágenes y otros datos relacionados con dicha entrada. Estas herramientas digitales utilizan algoritmos para encontrar las distintas páginas y, a continuación, las organizan y muestran en lo que se denomina una página de resultados. Una vez que obtienes los resultados, te desplazas por las diferentes páginas web, etc., para encontrar la mejor información para el tema de tu búsqueda.

En otras palabras, un motor de búsqueda es su ayudante de información que hace el trabajo duro por usted.

Tenga en cuenta que los primeros motores de búsqueda no eran como los actuales. Eran muy primitivos y no tenían tantas funciones como los modelos actuales.

Además, no tenían muchos sitios o páginas web en los que buscar. Por lo general, la información que encontraban estos primeros motores de búsqueda estaba en el Protocolo de transferencia de archivos (FTP).

Se mantenían manualmente y no contenían mucha información. También consistían en archivos compartidos y no en los archivos que se ven hoy en la página de resultados de los motores de búsqueda.

Pero, como todo, una vez inventado el producto, otras personas brillantes se unieron a él y lo perfeccionaron. Eso es lo que ocurrió con los motores de búsqueda, como pronto verás.

¿Cuándo se creó el primer motor de búsqueda?

Una pregunta sencilla, pero no una respuesta sencilla.

Esto es objeto de debate.

- La mayoría de los sitios web que documentan la historia del motor de búsqueda afirman que Archie fue el primero. Técnicamente, tendrían razón, ya que se trataba de un motor de búsqueda. Sin embargo, Archie se diseñó para buscar en sitios FTP, no en la World Wide Web. Fue construido en 1987 en la Universidad McGill (aún así, algunos sitios web pueden decir que Archie fue construido y lanzado alrededor de 1990).

- Después de Archie vino Jughead o W3Catalog, creado por Oscar Nierstrasz en la Universidad de Ginebra en septiembre de 1993. Ese mismo año, y 2 meses después, se creó Aliweb (Archie Like Indexing for the Web). Este fue el que se considera el primer motor de búsqueda de la red mundial.

- Puede que algunas personas pongan a Veronica por delante de Jughead, ya que se supone que se creó en 1992. Pero lo único que hacía esta función de búsqueda era buscar nombres y títulos de archivos almacenados en sistemas de índices Gopher. Puede que no se pueda calificar como un verdadero motor de búsqueda.

- 1993 fue un año intenso para la creación de motores de búsqueda en su forma más primitiva. También existían World Wide Wanderer, JumpStation y RBSE spider, que se desarrollaron por la misma época. Uno de los inconvenientes de estos primeros sistemas era que no se encontraban resultados a menos que se tuvieran títulos exactos en la búsqueda de palabras clave.

- 1994 fue otro año agitado en el que nacieron Infoseek, EINet Galaxy y Yahoo.

- Para no quedarse atrás, 1995 vio la creación de LookSmart, Excite y AltaVista. AOL compró WebCrawler ese año, y Netscape recurrió a Infoseek como motor de búsqueda por defecto.

- Después, en 1996, Internet vio cómo se añadían Inktomi: HotBot, Ask.Com o AskJeeves a la creciente lista de motores de búsqueda.

- 1996 también es famoso por otra creación. Se inventó BackRub, y puede que haya sido el primer motor de búsqueda en utilizar backlinks. Lo que hace notable a este pequeño motor de búsqueda es que es la base de la que surgió Google.

BackRub también se hizo famoso por ser el primero en clasificar los sitios web en función de la autoridad y también según la notación de citas. Estos fueron los motores de búsqueda de los 90 que ayudaron a construir la actual cosecha de motores de búsqueda que todo el mundo utiliza hoy en día.

¿Quién inventó el motor de búsqueda?

Cuando se trata de historia, siempre hay mucho debate sobre la fecha real de la invención. A veces este debate se extiende a quién creó qué.

- Por ejemplo, en muchos sitios web sólo figuran los nombres de las universidades donde tuvo lugar la invención o creación. Otros sitios web proporcionan el nombre real del estudiante o profesor que fue la persona principal implicada. Por ejemplo, en un sitio web se dice que Archie se creó en la Universidad McGill. Pero en otro sitio web, el nombre del estudiante que creó Archie figura como Alan Emtage.

- Más gente recuerda el nombre del inventor de la World Wide Web, Sir Tim Berners-Leeque trabajaban en el CERN (Suiza) que recordarían el nombre del creador del World Wide Wanderer, Matthew Gray.

- O quizá recuerden los nombres de Bob Kahn y Vint Cerf, que en 1974 inventaron la tecnología TCP/IP de la que hoy no puede prescindir Internet. Recordarán a esos dos hombres porque ahora trabajan para Google, pero no recordarán a quien creó a Jughead, Oscar Nierstrasz.

En esencia, es mejor decir que hubo un grupo de individuos que fueron capaces de mejorar los diseños y la tecnología existentes y que inventaron el motor de búsqueda de los años 90.

Todos ellos han participado en el desarrollo de los modernos motores de búsqueda que clasifican los sitios web y ayudan a encontrar rápidamente la información que se necesita.

¿Cuándo empezó el SEO? Antecedentes del SEO

Aquí está la leyenda y aquí está la realidad. La mayoría de la gente se decanta por la leyenda, ya que es más interesante y proporciona un vínculo con la música rock.

Así que vamos con eso.

Cuenta la leyenda que el mánager del famoso grupo de rock Jefferson Starship estaba disgustado por la baja clasificación que recibía su grupo en distintos motores de búsqueda.

Según cuenta la historia, él fue quien estuvo detrás del desarrollo del SEO u optimización de motores de búsqueda. El año en que empezó fue anterior al inicio oficialmente reconocido de las prácticas SEO.

Se dice que el inicio oficial tuvo lugar en 1997. Probablemente, el SEO comenzó en 1991, cuando aparecieron los primeros motores de búsqueda en Internet. Sin embargo, el término no fue utilizado hasta febrero de 1997 por John Audette, de Multimedia Marketing Group.

Es posible que haya otras historias sobre cómo empezó el SEO. Mucha gente puede atribuir el mérito a BackRub, ya que empezó a utilizar la notación de autoridad y citación para clasificar los sitios web en su página de resultados.

Si uno quiere ser honesto, debería decir que el SEO comenzó mucho antes de 1997, y BackRub, ya que los usuarios de la World Wide Web tenían que utilizar palabras clave para encontrar la información que necesitaban sobre cualquier tema. Las palabras clave siempre han sido una estrategia SEO de primer orden, y preceden a las anotaciones de citas y a la autoridad en al menos 6 a 10 años.

¿Cómo ha evolucionado el SEO?

Aunque Google ha sido el actor dominante en el desarrollo del SEO, su contribución y dominio no se produjeron hasta mucho después de que el SEO hubiera evolucionado a un nivel más avanzado.

Siempre ha habido una estrategia empleada por los propietarios de sitios web para conseguir una mayor visibilidad, y son las estrategias las que cambiaban a medida que se iban viendo diferentes necesidades que había que satisfacer.

Al principio, bastaba con utilizar palabras clave para que la gente llegara a tu sitio web. No había tantos sitios web y nadie necesitaba un contenido real para atraer tráfico a su puerta.

A medida que crecía la competencia, también lo hacían las diferentes estrategias. Las palabras clave dejaron de ser suficientes y los propietarios de sitios web empezaron a utilizar el marketing por correo electrónico, creación de enlacese incluso anuncios de pago en las pocas redes sociales que existían entonces.

Con el tiempo, surgió otra necesidad. La pregunta a responder era, ahora que tienes el tráfico, ¿cómo mantienes a tus visitantes en el sitio para que realicen una compra o rellenen un formulario, etc.? Esta necesidad llevó al desarrollo de grandes contenidos.

Pero un gran contenido no era suficiente, por lo que la experiencia del usuario se convirtió en una gran prioridad. Esto llevó a la creación de vídeos, imágenes y una navegación sencilla que ayudara a mantener al visitante en el sitio hasta que se convirtiera en cliente.

Estos estrategias se siguen utilizando hoy en día, pero se han refinado debido al dominio de Google y al uso de algoritmos y otros criterios de clasificación que otorgan un gran valor a los diferentes contenidos y usabilidad de los sitios web.

Inicio SEO: 'El Salvaje Oeste': Los años 90

El término Salvaje Oeste puede inducir a error en lo que respecta al uso de Internet en los años 90. Pero, al mismo tiempo, también puede ser una analogía adecuada debido a las limitaciones del gobierno y las empresas tecnológicas de la época.

En el viejo oeste salvaje de la historia de Estados Unidos había leyes, pero era difícil hacerlas cumplir. Además, los sheriffs y jueces inventaban sus propias leyes y castigos para quienes consideraban infractores de la ley.

Esta situación facilitaba a los delincuentes y pistoleros desplazarse de un condado a otro, ya que cuando eran buscados en un condado, podían ir a otro donde no se les buscaba y vivir la vida como querían.

Esto hacía que a veces fuera muy peligroso vivir en aquellos días del salvaje oeste. Lo mismo puede aplicarse a la Internet de los años 90. La aplicación de la ley no era universal. La aplicación de la ley no era universal si había alguna ley que se ocupara de actividades específicas de Internet.

En aquella época, los internautas tenían mucha libertad para utilizar determinadas palabras clave como títulos de sitios web, por ejemplo, www.whitehouse.com, que era un sitio porno. En los años 90, debido a la infancia de Internet, no se sabía mucho y poca gente pensaba que no se podía hacer mucho daño en la red mundial.

A medida que los gobiernos se percataron de los peligros que conllevaba una Internet libre, las leyes empezaron a cambiar y se establecieron controles más estrictos sobre los usuarios y los motores de búsqueda.

Probablemente, la mayor diferencia entre el Internet actual y el de los 90 no es sólo la normativa que regula Internet, sino que la velocidad era mucho menor y había menos sitios basura.

A medida que la tecnología crecía y cambiaba, también lo hacía Internet, lo que acabó atrayendo la atención de los distintos gobiernos, que implantaron más leyes para reprimir a los propietarios y usuarios de sitios web que iban por libre.

Las tácticas de sombrero negro adquieren mala reputación: Principios de la década de 2000 - 2005

Cuando se creó el primer motor de búsqueda, puede que no hubiera muchas reglas que seguir. Los motores de búsqueda estaban en pañales y no mucha gente tenía una idea muy clara de lo que eran buenas y malas prácticas de SEO.

Pero con el paso de los años y el desarrollo de los primeros motores de búsqueda, las reglas se convirtieron en la norma. Las normas que se desarrollaron junto con los motores de búsqueda acabaron dividiendo el SEO en sombrero blanco y sombrero negro divisiones.

El SEO de sombrero blanco se consideraba una estrategia ética, mientras que las prácticas de SEO de sombrero negro eran poco éticas. Estas últimas violaban las normas de los motores de búsqueda. Las personas que empleaban técnicas de sombrero negro lo hacían por los resultados positivos que aportaban a cualquier sitio web que las utilizara.

Si no le parecen malas estrategias, lo son. Utilizarlas en tu sitio web puede meterte en muchos problemas. La razón es que las estrategias de sombrero negro son violaciones de los términos de servicio del motor de búsqueda.

Si le descubren utilizando estas estrategias, su sitio web y su negocio se verán perjudicados. Tres trucos de sombrero negro comunes son:

- relleno de palabras clave,

- letras blancas sobre fondo blanco, o

- enlaces de compra.

El uso de estas diferentes técnicas poco éticas puede hacer que su sitio web sea desindexado, perderá su posicionamiento y tráfico web, e incluso puede que tenga que cerrar su negocio.

El beneficio a corto plazo que se obtiene al utilizar estas estrategias poco éticas se esfumará en cuanto Google u otro motor de búsqueda descubra que las está utilizando. Lo que les da su mala reputación es el hecho de que el motor de búsqueda considera que esas técnicas van en contra de las normas y crean un terreno de juego injusto para los sitios web de menor categoría.

Para mantener una buena reputación de su sitio web, mantener su clasificación y tráfico, etc., debe practicar lo que los motores de búsqueda deciden que son prácticas de sombrero blanco. Estrategias SEO todo el tiempo.

La revolución de Google

Larry Page y Sergey Brin estudiaban o estudiaban en la Universidad de Stanford cuando crearon su pequeño motor de búsqueda. No era más que otro motor de búsqueda con una vuelta de tuerca. Añadieron un par de criterios de clasificación para ayudar a clasificar los muchos sitios web que han aparecido en línea en los últimos 5 o 6 años.

La empresa ni siquiera se llamaba Google en aquel momento. Se llamaba BackRuby sus fundadores tenían objetivos muy ambiciosos cuando pusieron en marcha este motor de búsqueda.

No inventaron un producto nuevo, sino que se basaron en lo que ya existía y se dedicaron a mejorar los diseños y las operaciones existentes. Pero ocurrieron dos cosas que allanaron el camino para que Google, o BackRub, se convirtiera en un gigante de esta industria.

Fórmula de Page Rank

En primer lugar, otros buscadores anteriores sufrían por el mal uso y el abuso de las palabras clave. Algunos también tenían problemas con el contenido, ya que el relleno de palabras clave y el texto oculto se convirtieron en la norma en los años 90.

El fundador de Google, Larry Page, desarrolló la fórmula Page Rank, que ayudó a aclarar este lío e inició el uso de la autoridad como criterio de clasificación. BackRub, en ese momento, fue capaz de deshacerse de gran parte del spam que estaba arruinando Internet.

Google Web Crawler

El segundo hecho que impulsó a Google a la fama fue su asociación con Yahoo. Este último utilizó Google para impulsar sus páginas web, y eso fue todo lo que necesitó el primer motor de búsqueda para convertirse en el jugador dominante en el juego de Internet.

El rastreador web de Google y el algoritmo Page Rank fueron revolucionarios y ayudaron a convertir a Google en la potencia que es hoy en día. Dado que Google decidió que la creación de enlaces era muy importante, todo el mundo se subió al carro y comenzó la estrategia de creación de enlaces SEO.

Ese fue un problema al que la empresa tuvo que hacer frente en los últimos años. Sin embargo, Google no dejó de revolucionar el motor de búsqueda. Desarrollaron su barra de herramientas, que proporcionaba puntuaciones del rango de página de los sitios web.

Esto se vio impulsado por su aparición en Internet Explorer de Microsoft. Esto no significa que Google no cometiera errores. El Adsense original se convirtió en un problema, y al igual que la construcción de enlaces, la compañía tuvo que hacer cambios y solucionar el problema que habían causado inicialmente.

La revolución de Google básicamente alteró el panorama de los motores de búsqueda y cambió la forma de clasificar los sitios web.

¿Cómo han cambiado los algoritmos de Google?

Google ha creado un sistema de algoritmos muy complejo para clasificar sitios web, etc. Los algoritmos se diseñaron para recuperar datos de su índice y publicar los resultados inmediatamente en su sitio web.

Para ello, el motor de búsqueda tuvo que combinar factores de clasificación con sus algoritmos para asegurarse de que los sitios web más relevantes ocuparan los primeros puestos en la página de resultados de búsqueda.

Cuando Larry Page creó PageRank en 1996, supuso un cambio revolucionario en los sistemas de clasificación. Sin embargo, pasaron 7 años más antes de que Google introdujera cambios en el algoritmo.

2003 Google Florida

Fue entonces cuando apareció Florida. Google diseñó esta actualización del algoritmo para filtrar los sitios web que contenían enlaces de baja calidad. Desafortunadamente para muchos sitios web y pequeñas empresas, Google lanzó esta actualización en Navidad que también incluía enlaces mal etiquetados. Esto perjudicó a muchos negocios en ese momento.

2004 Google Trust Rank

Al año siguiente, Google introdujo TrustRank. Filtraba los sitios web que utilizaban técnicas de sombrero negro, así como el spam. También proporcionó una clasificación de confianza de diferentes sitios web, para que los usuarios de su motor de búsqueda tuvieran acceso a los sitios de mayor calidad.

Estos pocos ejemplos proporcionan a todo el mundo una pequeña idea de cómo Google intentó mejorar las búsquedas en Internet para los internautas. A partir de septiembre de 2022, Google ha publicado su último cambio en su algoritmo central.

El problema de mantenerse al día con estos cambios es que Google tiende a lanzar miles cada año. No es como en los primeros tiempos, cuando solo introducían unos pocos cada año.

2010 Google Caffeine

Google Caffeine fue una importante actualización del algoritmo del motor de búsqueda de Google en 2010. Se diseñó para mejorar la velocidad, la precisión y la relevancia de los resultados de búsqueda.

La principal característica de la actualización era su mayor velocidad de indexación, que le permitía indexar páginas web mucho más rápido y con mayor precisión que antes.

2011 Google Panda

Al año siguiente, en 2011, Google lanzó su primera gran actualización del algoritmo, conocida como "Google Panda."

Esta actualización se diseñó para reducir la visibilidad de los sitios de baja calidad en las SERP y recompensar a los sitios de mayor calidad. Tuvo un gran impacto en los sitios web, algunos de los cuales sufrieron una drástica caída en sus posiciones en las SERP. Google Panda también introdujo una serie de criterios para juzgar la calidad de un sitio web, como la profundidad del contenido, la relevancia de las palabras clave y la experiencia del usuario.

2011 Google Freshness

A finales de año, Google lanzó su actualización Freshness. Esta actualización se centró en la actualidad del contenido, lo que significa que Google empezó a valorar el contenido que era más reciente.

Las páginas que llevaban tiempo sin actualizarse se desplazaban hacia abajo en las SERP, mientras que se daba prioridad a las más recientes.

Esquema 2011

En 2011, se creó el marcado schema como un tipo de microdatos para ayudar a los motores de búsqueda a comprender la intención de una consulta. Esquema.org muestra todas las variedades posibles de marcado schema.

Las clasificaciones no tienen en cuenta Schema. Schema, por otro lado, puede darle visibilidad en las páginas de resultados de los motores de búsqueda (SERP) por medio de contenidos enriquecidos y destacados. fragmentos.

2012 Google Penguin

La actualización de Google Penguin se centró en el spam web, especialmente en los sitios que utilizaban tácticas manipuladoras de creación de enlaces para mejorar su clasificación. La actualización afectó a millones de sitios web, y muchas empresas que utilizaban estrategias de creación de enlaces cuestionables vieron caer sus clasificaciones. Fue la mayor actualización del algoritmo de Google desde Panda y tuvo un gran impacto en la industria del SEO.

2013 Google Hummingbird

En 2013, Google lanzó el algoritmo Google Hummingbird, y cambió para siempre la forma en que buscamos en Internet. Para muchos, Hummingbird representó la alteración más significativa del algoritmo fundamental de Google desde su introducción en 2001.

El algoritmo se diseñó para mejorar la precisión de los resultados de búsqueda mediante una mejor comprensión del lenguaje natural de las consultas.

Cosas, no cadenas. El Gráfico de Conocimientos permite buscar cosas, personas o lugares que Google conoce y obtener inmediatamente información relevante para la consulta. Google utiliza estos datos para mejorar sus resultados de búsqueda.

Cuando alguien realiza una búsqueda de uno de los miles de millones de entidades o hechos almacenados en el Knowledge Graph, pueden aparecer varios tipos de "paneles de conocimiento", "cajas de conocimiento" y "carruseles de conocimiento".

No sólo tiene en cuenta las palabras clave, sino también el contexto de la consulta. Esto significa que puede entender mejor la intención subyacente a cada consulta y ofrecer resultados más relevantes. Se creó para gestionar mejor las consultas en lenguaje natural y la búsqueda conversacional.

2014 Google Pigeon

Google revolucionó la experiencia en línea de las empresas locales con su actualización del algoritmo "Pigeon". Facilitó más que nunca la localización de resultados de búsqueda relevantes y cercanos. Para aquellos que optimizaban sus prácticas de SEO, Pigeon era una poderosa herramienta que permitía aumentar la visibilidad cuando los usuarios buscaban en las proximidades, lo que permitía a los propietarios de pequeñas empresas elevarse por encima de la competencia estándar.

2015 Google Móvil Actualización AKA "Mobilegeddon"

Google lanzó otra actualización importante en 2015, bautizada como "Google Mobilegeddon". Esta actualización se centró en potenciar los sitios web optimizados para dispositivos móviles. Esto significaba que los sitios que no estuvieran optimizados para dispositivos móviles serían más difíciles de encontrar en los resultados de los motores de búsqueda y, por tanto, recibirían menos visitas.

Resultados de búsqueda más rápidos, mejores y contextuales: Finales de 2010 - 2020

Google ha realizado enormes avances en los últimos años para ofrecer a sus usuarios resultados de búsqueda más rápidos, precisos y contextuales.

Para empezar, Google ha implementado una serie de mejoras en la velocidad de su motor de búsqueda. Las páginas se cargan ahora más rápido que nunca y los algoritmos de Google se han vuelto mucho más eficientes a la hora de ofrecer resultados relevantes.

Google también ha realizado importantes avances en inteligencia artificial (IA). Desde la tecnología de reconocimiento de voz hasta los algoritmos de aprendizaje automático, pasando por el reconocimiento de imágenes, la IA se utiliza cada vez más para mejorar la experiencia del usuario en las plataformas de Google.

2015 Google Rankbrain

2015 fue un gran año para Google, y la introducción de Rankbrain fue sin duda un momento importante.

Rankbrain es un sistema de aprendizaje automático que Google utiliza para ayudar a ordenar los resultados de búsqueda. Utiliza inteligencia artificial para analizar los resultados de las consultas de búsqueda y ayuda a Google a ofrecer resultados más relevantes a los usuarios.

2016 Google Possum

Se diseñó para ofrecer resultados más localizados en las búsquedas locales, y puede tener un gran impacto en los esfuerzos de optimización de motores de búsqueda (SEO) locales.

En esencia, Possum está diseñado para evitar que los resultados se solapen demasiado y ayudar a las empresas locales a competir mejor con las nacionales o internacionales. Tiene en cuenta la dirección física del buscador y la dirección del negocio en cuestión a la hora de presentar los resultados.

2017 Google Fred

Este algoritmo se diseñó para castigar aún más a los sitios web ineficaces que contenían un número excesivo de publicidad y un número bajo de contenidos de calidad.

Si su sitio web ha estado utilizando estrategias de optimización de motores de búsqueda poco éticas, lo más probable es que haya notado una caída del tráfico después de que Google adoptara Fred.

2018 Google Medic

Este algoritmo ayuda a clasificar los sitios web con autoridad médica, como la Clínica Cleveland y la Clínica Mayo, por encima de los que no tienen ninguna autoridad médica.

Quienquiera que haya preguntado al Dr. Google diversas cuestiones médicas y haya recibido respuestas es consciente de lo crucial que es contar con fuentes médicas fiables en los resultados de búsqueda.

2019 BERT

No todos los cambios, sin embargo, se notan, pero son efectivos, y todos tratan de mejorar los esfuerzos de búsqueda del internauta. Un ejemplo es que el cambio BERT de 2019 pretendía mejorar el cambio Hummingbird de 2013.

El BERT también se diseñó para analizar la intención de búsqueda, así como palabras clave de cola larga. BERT debía dar prioridad a estas estrategias SEO.

Revisión de Rich Snippet 2019

Los fragmentos destacados son un tipo especial de resultado de búsqueda que Google muestra en la parte superior de la página de resultados de su motor de búsqueda. Estos fragmentos suelen extraerse del contenido de un sitio web e incluyen un resumen de la respuesta a la consulta del usuario, así como un enlace al sitio web original.

Todo el mundo quiere estar en ellas, pero pocos saben cómo conseguirlo.

Pero si consigues aparecer en un Snippet Destacado, ¡te habrás sacado la lotería! Cualquier consulta del motor de búsqueda puede tener potencialmente un Featured Snippet al lado, por lo que tu contenido puede obtener una gran exposición.

Pero conseguirlo no es fácil y requiere mucho ensayo y error.

Pero si puedes hacerlo, cosecharás los frutos en poco tiempo.

Las principales actualizaciones de calidad de Google de 2019

Las actualizaciones del núcleo de Google han sido una parte importante de su algoritmo desde que se introdujo por primera vez en el año 2000. El algoritmo central de Google consiste en un conjunto de reglas y directrices que determinan qué sitios web aparecen para una consulta de búsqueda determinada. Estas actualizaciones se publican periódicamente para mantener los resultados del motor de búsqueda actualizados y relevantes.

Las principales actualizaciones de Google están diseñadas para mejorar la relevancia de los resultados de búsqueda asegurándose de que el contenido más relevante aparezca en primer lugar.

Google quiere asegurarse de que los usuarios obtienen los mejores resultados posibles para sus consultas, por lo que disponer de contenido de calidad es esencial para el éxito de un sitio web. Esto incluye contenidos bien estructurados, con el formato adecuado y que contengan información precisa.

Mejor experiencia de usuario, contexto y valor: de 2020 hasta ahora

2021 Page Experience y Core Web Vitals (CWV)

Google se esfuerza por crear una experiencia web más agradable para todos los usuarios, independientemente del navegador que utilicen o del tipo de dispositivo.

Examina la experiencia de la página en función de lo fácil y valioso que los usuarios encuentran su tiempo en su sitio web, independientemente de si su sitio web les proporcionó la información que buscaban. Miden el rendimiento de la página en función de cinco elementos clave: facilidad de uso para móviles, navegación segura, cumplimiento del protocolo de seguridad HTTPS e intersticiales intrusivos, así como Core Web Vitals.

Core Web Vitals es la forma que tiene Google de medir la experiencia de usuario de un sitio web. Evalúa la rapidez con la que una página carga su contenido más importante, lo fácil que es orientarse en ella y si aspectos como el desplazamiento se realizan sin problemas.

2021 Modelo unificado multitarea de Google (MUM)

Google revoluciona aún más las capacidades de su motor de búsqueda con la introducción de Multitask Unified Model (MUM), una evolución 1000 veces más potente que BERT. MUM combina el procesamiento del lenguaje natural y otras tecnologías, lo que permite a Google responder a consultas complejas de los usuarios y crear una experiencia aún mejor contextualizada para ellos. El objetivo de MUM es utilizar un único modelo entrenado para gestionar simultáneamente la indexación, la recuperación de información y la clasificación.

2022 Contenido útil de Google

Google introduce la actualización de contenido útil para ofrecer la mejor experiencia posible a sus usuarios. Fomenta el material original, útil y fácil de usar en los resultados de búsqueda. Esta señal única ayuda a los sistemas de clasificación a identificar el contenido que ofrece lo que los visitantes esperan y necesitan, dando más visibilidad a aquellos que elaboran recursos atractivos, informativos y valiosos para su audiencia. También elimina los contenidos que no cumplen las expectativas de los visitantes, garantizando que la gente reciba información de calidad en todo momento.

Principales conclusiones

Los motores de búsqueda han recorrido un largo camino desde los primeros días de Internet. Siguen evolucionando y cambiando sistemáticamente. A medida que Google actualiza su algoritmo, es importante que nos mantengamos al tanto de estos cambios y adaptemos nuestra estrategia a ellos. Estrategias SEO en consecuencia. Quizá se pregunte adónde nos llevará el futuro de las búsquedas. El tiempo lo dirá. Pero una cosa es segura: el mundo del SEO siempre está cambiando y evolucionando. Y tenemos que estar preparados para lo que venga.